고성능 LLM 지원

모델에 최적화된 프레임워크에서 실행

비용 효율성

기본 사양 및 고객 맞춤 사양 제공

전문 기술 제공

시스템 상시 기술지원

높은 보안성

분리된 서버 시스템 제공

활용 정보(Framework)

vLLM

vLLM은 LLM의 실시간 응답성과 효율적인 리소스 활용을 극대화한 고성능 추론/서빙 전용 프레임워크입니다. GPU 기반 인프라에서 초고속 토큰 생성, 메모리 최적화, 다중 요청 비동기 처리를 통해 최신 AI 애플리케이션에 최적화된 환경을 제공합니다. 수십 tok/s 이상의 속도와 낮은 지연 시간, 효율적인 메모리 활용을 바탕으로 다양한 AI 서비스에 빠르게 적용할 수 있습니다.

메모리 효율성: PagedAttention 기술로 VRAM 사용량을 줄이며, 긴 컨텍스트도 효과적으로 처리.

비동기 요청 처리: 요청을 비동기로 처리하고 배치 기술을 통해 GPU 자원을 효율적으로 운영.

확장성과 호환성: 단일/다중 GPU, 가상 머신, 베어메탈 등 다양한 환경에서 실행 가능.

GPU 최적화: FP16, BF16, CUDA 연산 최적화를 통해 높은 성능을 발휘.

관리자 제어 기능: 사용자 정의 설정, 모니터링, 동적 관리 기능 제공.

모델 및 인프라 지원: 한국어 LLM 지원과 함께 VM, 베어메탈 환경 등 다양한 배포 옵션 제공.

고성능 챗봇, 문서 요약, RAG 기반 질의응답 시스템

엔터프라이즈 AI 백엔드 서버

LLM 기반 SaaS 기능(API 제공형 서비스)

멀티 유저 환경의 실시간 응답 시스템

단위: 원(부가세 별도)

| GPU 모델 | 배포 유형 | 테스트 결과 | 이용료 | |||||

|---|---|---|---|---|---|---|---|---|

| 환경 | 실행 LLM | Token/s(초) | DRAM 사용량 | VRAM 사용량 | 일 | 월 | ||

| Nvidia RTX PRO 6000 | 가상 서버 |

Nvidia RTX PRO6000 x 1 8vCPU / 120GB / 100GB SSD vllm 0.9.1 |

GPT-OSS 120B | 100.72 tok/s | 63GB | 63473MB | 51,480 원 | 1,490,000 원 |

|

Nvidia RTX PRO6000 x 1 8vCPU / 120GB / 100GB SSD vllm 0.9.1 |

Gemma3 27B | 49.176 tok/s | 17.6GB | 19223MB | 51,480 원 | 1,490,000 원 | ||

|

Nvidia RTX PRO6000 x 2 16vCPU / 240GB / 100GB SSD vllm 0.9.1 |

Qwen3 235B | 54.344 tok/s | 134GB | 68189MB | 102,960 원 | 2,980,000 원 | ||

다양한 iwinv GPU 서버에서 LLM을 실행한 벤치마크 결과를 확인하고, 가장 적합한 하드웨어 자원을 선택할 수 있습니다.

테스트는 NGC 공식 컨테이너 nvcr.io/nvidia/pytorch:25.06-py3 환경에서 수행되었습니다. 본 결과 공개는 NVIDIA의 “Deep Learning Containers – Benchmarking” 문서에 따른 예외 조항에 근거합니다.

테스트 결과는 자사가 직접 실험한 수치로, NVIDIA의 공식 성능과 무관하며, 미세한 환경 차이에 따라 결과는 다를 수 있으니 참고용 데이터로 활용하시기 바랍니다.

LLM 정보

LLM 실행 시 CPU-GPU 혼합 사용은 효율성 향상에 필수적입니다. 모델 규모와 추론 프레임워크에 따라 적절한 GPU 및 메모리 사양이 달라지며, 양자화 모델의 경우 아래 가이드를 참고하시기 바랍니다.

| LLM 모델 | 매개변수 | 컨텍스트 길이 (tokens) |

성능(능력) | 바로가기 |

|---|---|---|---|---|

| gpt-oss | 20B | 128K |

- o3-mini보다 우수하며 o4-mini와 거의 동등한 수준의 추론 능력 보유 - 수학, 일반 문제해결, 도구 호출 등에서 뛰어난 성능 발휘 - MMLU, HLE 등 언어(이해/추론/작문) 능력 상위 수준 |

|

| 120B | ||||

| Qwen3 | 30B | 32K |

- 코드·수학·추론 등에서 상위 모델보다 뛰어난 MoE 아키텍처 적용 - 119개 국 다국어 지원 모델로써 한국어 처리 성능 우수 - 빠른 답변 속도와 향상된 코드 생성 능력 제공 |

|

| 32B | ||||

| 235B | ||||

| DeepSeek-R1 | 7B | 128K |

- 계산, 코딩, 응답 품질 등 GPT-4 이상 수준의 우수한 성능 - 중국어 및 영어에 능통, 준수한 한국어 이해도 및 응답 성능 |

|

| 14B | ||||

| 70B | ||||

| 671B | ||||

| Gemma3 | 12B | input : 128K output : 8192 |

- 경량화 기반 메모리 효율성 우수 - GPT-3.5 기반의 안정적 성능 - 다국어 지원 모델로써 한국어 처리 성능 우수 |

|

| 27B | ||||

| Llama4 - Scout | 17B | 10M |

- 최대 10M 토큰의 초장기 문맥 유지 가능 - 긴 문서 요약, 지속 대화 성능, 코드베이스 분석에 특화(정밀 추론 성능은 일반적)- 영어 중심 설계, 한국어 성능 다소 낮음 |

|

| Llama3.3 | 70B | 128K |

- GPT-4 Turbo급 고성능 추론 및 대화 가능 - 추론, 대화, 코딩, 지식 응답 성능 우수 - 다국어 학습 기반 모델, 한국어 성능 준수 |

|

| Llama3.2 | 11B | 128K |

- 경량 모델 대비 뛰어난 코딩 처리 성능 및 우수한 안정성 - 다국어 학습 기반 모델, 한국어 성능 일부 한계 존재 |

|

| 90B |

- GPT-4 Turbo급 대화, 추론, 지식 응답 가능 - 대규모 파라미터 기반의 다국어 학습, 한국어 대응력 우수 |

|||

| Phi4 | 14B | 32K |

- 빠른 응답 속도, GPT-3.5급 논리 추론, 요약 가능 - 경량화에 최적화된 모델 - 한국어의 정확도, 유창성 다소 낮음 |

|

| HyperCLOVA X SEED | 1.5B | 16K |

- 온디바이스 및 저사양 환경에 최적화된 경량 모델 - GPT-3.5 계열 소형 모델 수준의 정확도 및 안정성 - 한국어 기반 지시어 및 질문 응답 성능 매우 우수 |

|

| 3B |

모델 크기별 요구 사양 가이드 (양자화 LLM Q4 기준)

| 모델 | 매개변수 | DRAM 최소 사양 | 실행 환경 |

|---|---|---|---|

| 초소형 | ~ 2B 파라미터 | 4 ~ 8GB | 노트북 수준의 GPU 또는 일부 CPU-only 환경에서도 실행 가능 |

| 소형 | 2B ~ 10B 파라미터 | 8 ~ 16GB | 일반 소비자용 GPU 가능 4090 등 |

| 중형 | 10B ~ 20B 파라미터 | 16 ~ 32GB | 4000Ada 이상 또는 RTX 4090/5090 Multi-GPU 구성 |

| 대형 | 20B ~ 70B 파라미터 | 32 ~ 128GB | A6000, PRO5000 Multi-GPU 구성 |

| 초대형 | 70B ~ 파라미터 | 128GB 이상 | PRO6000 Multi-GPU 구성 이상 |

- VRAM과 DRAM 조합 용량을 LLM 크기보다 더 높게 설정하시기 바랍니다. (약 1.2배)

- DeepSeek-R1 671B는 위 가이드와 달리 일반 소비자용 GPU(4090 등)에서 DRAM 1TB 구성 시 실행 가능합니다.

- LLM 및 소프트웨어를 사용하기 전 라이선스 및 이용약관 규정을 확인하시기 바랍니다.

AI 기반의 분석 및 시각화 서비스를 제공하는 Artificial Analysis 에서 LLM에 대한 더 다양한 자료를 참고할 수 있습니다. (해당 사이트는 정보 제공을 목적으로 공유하며, 스마일서브와는 무관합니다.)

GPU 사양 정보

iwinv GPU 서버는 GPU Pass-through로 할당되는 가상 서버, 즉시 활용 가능한 온디맨드 베어메탈 서버, 원하는 사양으로 직접 구성하는 맞춤형 GPU 서버 중 선택할 수 있습니다. 사용 목적 및 예산에 맞춰 인프라 자원을 자유롭게 선택하시기 바랍니다.

가상서버(Virtual Machine)

단위: 원(부가세 별도)

| GPU Type | 상품명 | 제공사양 | AI 프레임워크 | 이용료 | |||||

|---|---|---|---|---|---|---|---|---|---|

| GPU | vCPU | Memory | Storage(OS) | Traffic | 일 | 월 | |||

|

4090 New |

4090.G1 | 1 | 8 | 84GB (DRAM 60GB + VRAM 24GB) |

SSD 100GB |

20 GB/일 (월 600 GB) *초과 시 구간 요금제 적용 |

LLM 용 Ollama & vLLM |

18,500 원 | 495,000 원 |

| 4090.G2 | 2 | 16 | 168GB (DRAM 120GB + VRAM 48GB) |

37,000 원 | 990,000 원 | ||||

| 4090.G4 | 4 | 32 | 336GB (DRAM 240GB + VRAM 96GB) |

74,000 원 | 1,980,000 원 | ||||

|

Tesla T4 IDC Opt. |

T4.G1 | 1 | 6 | 76GB (DRAM 60GB + VRAM 16GB) |

6,260 원 | 169,000 원 | |||

| T4.G2 | 2 | 12 | 152GB (DRAM 120GB + VRAM 32GB) |

12,520 원 | 338,000 원 | ||||

| T4.G4 | 4 | 24 | 304GB (DRAM 240GB + VRAM 64GB) |

25,040 원 | 676,000 원 | ||||

|

4000Ada IDC Opt. |

4000Ada.G1 | 1 | 8 | 80GB (DRAM 60GB + VRAM 20GB) |

9,200 원 | 248,500 원 | |||

| 4000Ada.G2 | 2 | 16 | 160GB (DRAM 120GB + VRAM 40GB) |

18,400 원 | 495,000 원 | ||||

| 4000Ada.G4 | 4 | 32 | 320GB (DRAM 240GB + VRAM 80GB) |

36,700 원 | 990,000 원 | ||||

|

V100 IDC Opt. New |

V100.G1 | 1 | 8 | 92GB (DRAM 60GB + VRAM 32GB) |

13,700 원 | 369,000 원 | |||

| V100.G2 | 2 | 16 | 184GB (DRAM 120GB + VRAM 64GB) |

27,400 원 | 738,000 원 | ||||

| V100.G4 | 4 | 32 | 368GB (DRAM 240GB + VRAM 128GB) |

54,800 원 | 1,476,000 원 | ||||

|

A6000 IDC Opt. |

A6000.G1 | 1 | 8 | 108GB (DRAM 60GB + VRAM 48GB) |

18,200 원 | 490,000 원 | |||

| A6000.G2 | 2 | 16 | 216GB (DRAM 120GB + VRAM 96GB) |

36,300 원 | 980,000 원 | ||||

| A6000.G4 | 4 | 32 | 432GB (DRAM 240GB + VRAM 192GB) |

72,600 원 | 1,960,000 원 | ||||

|

A100 IDC Opt. New |

A100.G1 | 1 | 8 | 100GB (DRAM 60GB + VRAM 40GB) |

29,300 원 | 790,000 원 | |||

| A100.G2 | 2 | 16 | 200GB (DRAM 120GB + VRAM 80GB) |

58,600 원 | 1,580,000 원 | ||||

| A100.G4 | 4 | 32 | 400GB (DRAM 240GB + VRAM 160GB) |

117,200 원 | 3,160,000 원 | ||||

|

PRO5000 IDC Opt. New |

PRO5000.G1 | 1 | 8 | 108GB (DRAM 60GB + VRAM 48GB) |

25,750 원 | 695,000 원 | |||

| PRO5000.G2 | 2 | 16 | 216GB (DRAM 120GB + VRAM 96GB) |

51,500 원 | 1,390,000 원 | ||||

| PRO5000.G4 | 4 | 32 | 432GB (DRAM 240GB + VRAM 192GB) |

103,000 원 | 2,780,000 원 | ||||

|

PRO6000 IDC Opt. New |

PRO6000.G1 | 1 | 8 | 216GB (DRAM 120GB + VRAM 96GB) |

55,200 원 | 1,490,000 원 | |||

| PRO6000.G2 | 2 | 16 | 432GB (DRAM 240GB + VRAM 192GB) |

110,400 원 | 2,980,000 원 | ||||

| PRO6000.G4 | 4 | 32 | 864GB (DRAM 480GB + VRAM 384GB) |

220,800 원 | 5,960,000 원 | ||||

신청 가능 존: KR1-Z07(4090, Tesla T4, RTX 4000 Ada, A6000), KR1-Z03(PRO5000, PRO6000) [참고사항]

NVIDIA 그래픽카드가 장착된 GPU 서버 이용 시, NVIDIA 드라이버는 고객이 직접 설치·사용하며, 해당 드라이버의 라이선스 조건 준수 여부는 고객의 책임입니다. 사용 전 NVIDIA 드라이버 라이선스를 반드시 확인하시기 바랍니다.

신청하기맞춤 서버(Custom Dedicated Server)

단위: 원(부가세 별도)

| 지원 소프트웨어 | GPU | CPU | RAM | Storage | LAN/Case/PSU | 금액 |

|---|---|---|---|---|---|---|

| Ollama, vLLM |

최대 4개 장착 가능 - AMD : w6800, 9700 - NVIDIA : 4000Ada, A6000, 6000Ada PRO5000, PRO6000 4090 blower |

1 x Xeon Silver 4314 (16C/32T) |

8 x 16~64GB (DDR4) |

SSD, NVMe - 내부: 2 x PCIe3.0 x2, 1 x SATA3(2.5") - 외부: 8 x SATA3(2.5"/3.5") Hot-swap |

LAN - 4 x 2.5Gbps(RJ45, Ethernet 전용) - 1 x IPMI 전용(RJ45) - 최대 2port 10Gbps NIC 장착 가능 (3GPU 이하 시) Case - SMILE Barebone4U PSU - ATX [2000/2500]W Single |

견적 문의 |

|

최대 8개 장착 가능 - AMD : w6800, 9700 - NVIDIA : 4000Ada, A6000, 6000ada PRO5000, PRO6000 4090 blower |

2 x Xeon Silver 4314 (32C/64T) |

32 x 16~64GB (DDR4) |

SSD, NVMe - 내부: 1 x PCIe3.0 x4 - 외부: 12 x SATA3(2.5"/3.5") Hot-swap |

LAN - 2 x 1Gbps(RJ45, Ethernet 전용) - 1 x IPMI 전용(RJ45) - 최대 2port 10Gbps NIC 장착 가능 Case - Tyan GPU B7129F83AV8E4HR-N-HE PSU - 6000W(3+1 2,000W RPSU, 80+ Platinum) - 4800W(3+1 1,600W RPSU, 80+ Platinum) |

견적 문의 |

GPU 사양 비교

| 제조사 | AMD | NVIDIA | |||||||

|---|---|---|---|---|---|---|---|---|---|

| 모델 | RX9060XT | W6800 | 9700 | PRO6000 | PRO5000 | A6000 | 4000Ada | RTX 4090 | Tesla T4 |

| 아키텍처 | AMD RDNA™ 4 | AMD RDNA™ 2 | AMD RDNA™ 4 | Blackwell | Blackwell | Ampere | Ada Lovelace | Turing | |

| GPU 메모리 | 16GB (GDDR6) |

32GB (GDDR6 ECC) |

32GB (GDDR6 ECC) |

96GB (GDDR7 ECC) |

48GB (GDDR7 ECC) |

48GB (GDDR6 ECC) |

20GB (GDDR6 ECC) |

24GB (GDDR6X) |

16GB (GDDR6) |

| GPU

메모리 대역폭 |

320 GB/s | 512 GB/s | 640 GB/s | 1,792 GB/s | 1,344 GB/s | 768 GB/s | 448 GB/s | 1,008 GB/s | 320 GB/s |

| CUDA | 2,048 | 3,840 | 4,096 | 24,064 | 14,080 | 10,752 | 6,144 | 16,384 | 2,560 |

| FP32 | 25.6 TFLOPs | 17.83 TFLOPS | 47.8 TFLOPS | 110 TFLOPS | 73.2 TFLOPS | 38.7 TFLOPS | 30 TFLOPS | 82.6 TFLOPS | 8.1 TFLOPS |

| TDP | 160W | 250W | 300W | 300W | 300W | 300W | 130W | 450W | 70W |

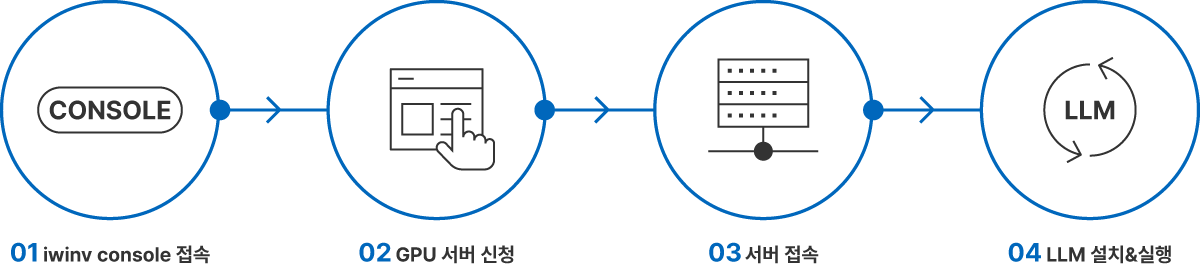

신청 방법

iwinv GPU 서버에서 LLM을 실행할 수 있는 방법을 아래 단계별로 손쉽게 따라하실 수 있습니다. (신청 매뉴얼 바로가기)

매뉴얼

아래 가이드를 통해 보다 쉽게 이용할 수 있습니다.